Stability AIは、新たな日本語向けの言語モデル Japanese StableLM Alpha のリリースを発表しました。このモデルは、日本のAIコミュニティに大きなインパクトをもたらすことが期待されています。本ニュースレターでは、この発表の詳細について探ります。

主要ポイント

パフォーマンスの高さ

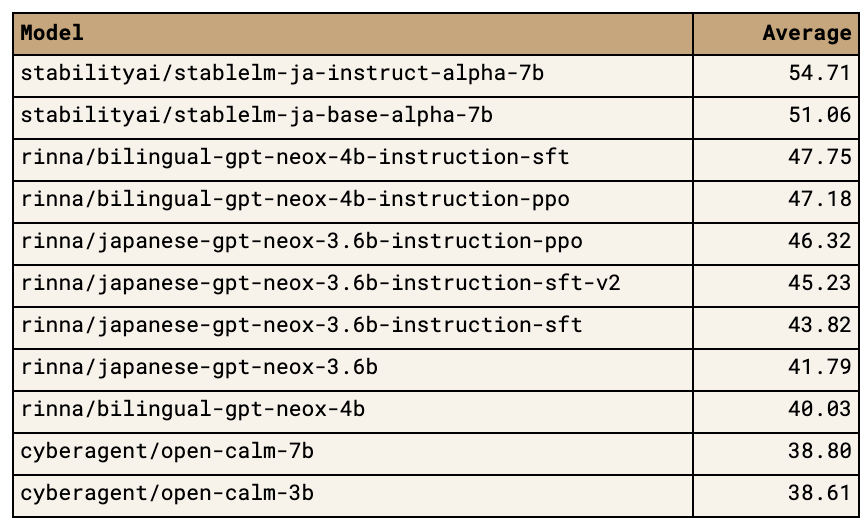

「パフォーマンスの高さ」とは、StableLMの性能の優れさを指しています。具体的には、StableLMは7十億パラメータという大規模なモデルであり、これにより複雑なタスクや細やかな言語表現を行うことができます。公開されている他の日本語モデルとの比較テストでも、StableLMは最も高い結果を出しており、これが「最も高いパフォーマンスを持っている」と評価されています。

ライセンス

「ライセンス」は、モデルの利用や配布に関する許可や制限を定めたものです。StableLM Base Alpha 7BはApache License 2.0のもとでリリースされています。このライセンスはオープンソースライセンスの一つで、商業利用が可能ですが、原著作者の著作権表示は必須です。一方、StableLM Instruct Alpha 7Bは研究目的のために作られ、専ら研究での利用が前提とされています。

多様な訓練データ

StableLMは、さまざまな情報源から取得された大量のデータを用いて訓練されています。具体的には、ウェブからの大規模なデータを中心に、日本語と英語のテキストが主体となっています。この他、2%のデータはプログラムのソースコードとして提供されているとのこと。これにより、モデルは多様な文脈や文化的背景を持つテキストを理解し、高い精度での言語生成が期待されます。

これらのポイントは、StableLMが国際的な言語モデル市場で注目される理由ともなっています。

Stability AIの目指す方向性

「私たちは日本の生成的AIエコシステムに貢献する大きな一歩を踏み出したことを誇りに思っています」と、Meng Lee プロジェクトリーダーは語っています。Stability AIは、日本の文化、言語、美学を反映したモデルの制作を続けることを目指しています。

Stability AIは、言語モデル技術の先駆者として、特に日本の市場における存在感を強化しているのが見受けられます。以下は、Stability AIの戦略や方向性に関する詳細です。

日本の生成的AIエコシステムへの貢献

Stability AIは日本のAIエコシステムにおける生成技術の向上と普及を目指しています。これにより、日本のAI技術が国際的にも一段と進化し、競争力を持つことが期待されます。

文化・言語・美学の反映

Meng Leeプロジェクトリーダーの発言によれば、Stability AIは日本の文化、言語、そして美学を反映したモデルの制作を強化していく方針を持っています。これは、単なる技術的な進化だけでなく、日本独特の価値観や感性を持つAIモデルの実現を目指していることを示しています。

継続的なモデル開発

Stability AIは、今後も日本市場向けのモデルを継続して開発していく意向です。これにより、さまざまな用途やニーズに応じたモデルが提供されることが期待されます。

総じて、Stability AIの目指す方向性は、技術的な優れた言語モデルを提供するだけでなく、日本の文化や言語、美学を深く理解し、それを反映したユニークなAIモデルの制作と普及に重点を置いていることが明らかです。

訓練と評価

訓練データ

Japanese StableLM Base Alpha 7B: このモデルは、主にインターネット上の大規模なデータを使用して訓練されています。訓練データは日本語と英語のテキストが中心ですが、2%はソースコードの形で含まれています。このような多様なデータを使用することで、モデルは様々な文脈や文化的背景を持つテキストをより正確に理解することができます。また、Stability AI Japanが作成したデータセットや、EleutherAI Polyglotプロジェクトの日本チームとの協力によるデータセットも使用されています。

評価

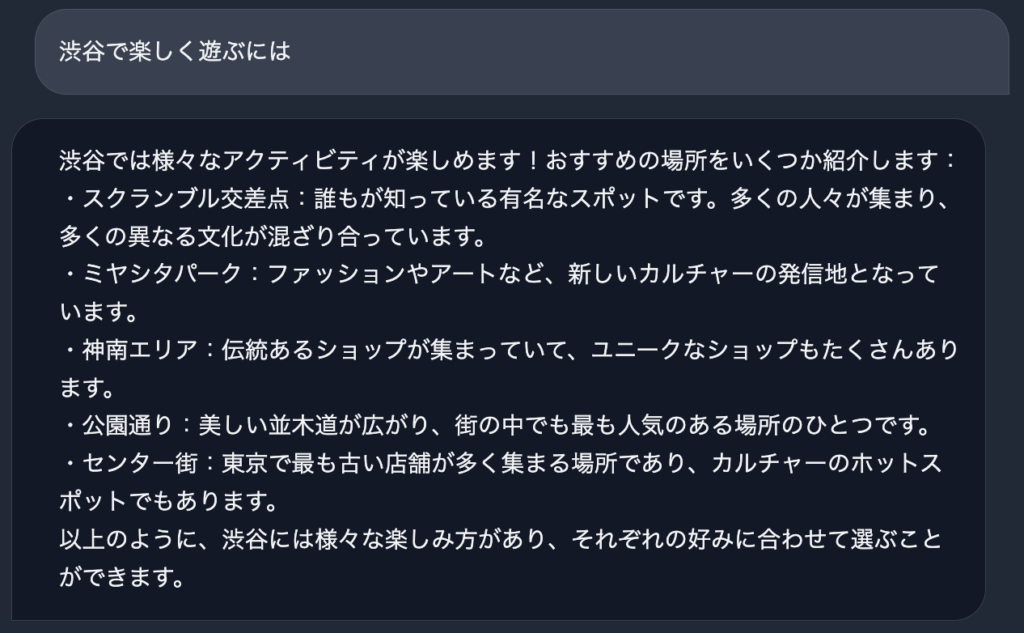

Japanese StableLM Instruct Alpha 7B: このモデルは、ユーザーの指示に従うように追加でチューニングされた言語モデルです。Supervised Fine-tuning(SFT)という方法が使用され、多くのオープンデータセットを使用して追加の訓練が行われています。SFTは、lm-evaluation-harnessによる評価スコアを大幅に向上させることが確認されています。Open LLM Leaderboardの慣習に従い、8つのタスクのスコアの平均が計算され、各モデルの全体的な評価に使用されます。Japanese StableLM Instruct Alpha 7Bのスコアは54.71であり、これにより他の日本語モデルを大きくリードしています。さらに、Stability AI Japanはこれらのモデルのテスト方法の評価を改善する作業も進めています。

訓練と評価は、AIモデルの性能を高めるための重要なステップです。特に、高品質なデータを使用して訓練を行い、様々なタスクでの性能を評価することにより、モデルの信頼性と有用性を確保することができます。

まとめ

Stability AIの日本向けモデルのリリースは、日本のAIエコシステムへの大きな一歩と言えるでしょう。この進展により、日本の開発者や研究者は、高度な言語モデルを活用してさらに多くのイノベーションを生み出すことが期待されます。