Alibaba Cloudは2023年8月25日、画像とテキストを理解する2つのオープンソースの大視野言語モデルを発表しました。これにより、画像処理とテキスト解析の能力を組み合わせた新たな応用が可能になります。以下では、この重要な発表に関する詳細を掘り下げていきます。

モデルのリリースと特徴

Alibaba Cloudは、以下の2つのモデルをオープンソースとして提供します。

Qwen-VL: 大視野言語モデル

- Qwen-VLはプレトレーニング済みの大視野言語モデルです。

- このモデルは英語と中国語の両方の画像とテキスト入力を理解する能力を持っています。

- 複数の画像に基づいたオープンエンドの質問に答えるといった視覚的なタスクを実行可能です。

Qwen-VL-Chat: 会話重調整バージョン

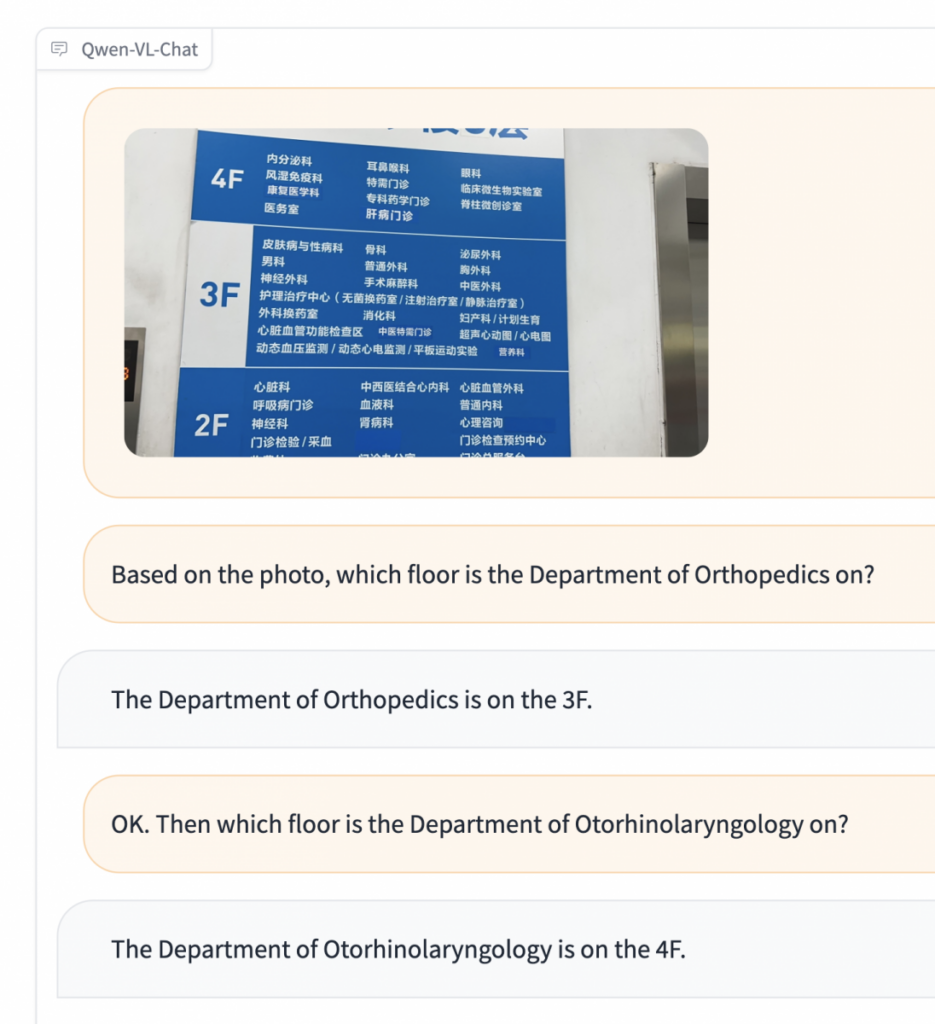

- Qwen-VL-Chatは、会話を重調整したバージョンです。

- 数学的な計算や複数の画像に基づいたストーリーの生成など、より高度なタスクを実行可能です。

- 複数のラウンドにわたるQ&Aをサポートし、さらに対話的な応用が期待されます。

これらのモデルはAlibaba CloudのAIモデルコミュニティModelScopeおよび協力的なAIプラットフォームHugging Faceでダウンロード可能です。

優れた性能と画像認識への影響

Alibaba Cloudによれば、これらのオープンソースモデルは他の類似モデルと比較して、以下の点で優れた性能を持っています。

- 高解像度の画像を理解する能力が高まり、画像認識の精度が向上しています。

- 画像とテキストを組み合わせて理解するため、複雑なタスクにも対応できます。

新たな応用の可能性

これらの大視野言語モデルのリリースにより、様々な新たな応用が考えられます。

メディアとニュース

- ニュースアウトレットは、これらのモデルを活用して画像のキャプションを生成することができます。

- 複数の画像に基づいてオープンエンドの質問に回答することで、情報をより詳細に伝えることができます。

視覚障害者への支援

- アリババグループは視覚障害者向けに取り組んでおり、これらのモデルもその支援の一環として活用されます。

- Qwen-VL-Chatの対話的な機能を活用して、視覚障害者が画像から情報を得る際のサポートを強化することが期待されます。

Alibaba Cloudの取り組み

これらのモデルのリリースは、Alibaba Cloudの高度なマルチモーダル能力の発展を示しています。これにより、画像や音声などの異なるデータタイプを統合して処理できる大視野言語モデルの可能性が拡大しました。これは研究者や商業組織にとって、新たなアプリケーション開発の可能性を切り開くものと言えるでしょう。

まとめ

Alibaba Cloudのオープンソース大視野言語モデルのリリースは、画像とテキストの理解を統合した新たな応用の可能性を提供しています。これにより、メディア、視覚障害者の支援、ショッピング体験の向上など、様々な領域での革新が期待されます。Alibaba Cloudの取り組みは、AI技術の進化と共に、私たちの日常生活に新たな可能性をもたらすことでしょう。